产业新知热门

加国央行再次疯狂加息 月供将暴涨 物价竟会这样变化

加国央行再次疯狂加息 月供将暴涨 物价竟会这样变化

无人幸免的购物节“大逃杀”

无人幸免的购物节“大逃杀”

兼职做自媒体这些天:有人年入五块四,有人时薪一百二

兼职做自媒体这些天:有人年入五块四,有人时薪一百二

瞄准数亿过敏人群,以过敏数字疗法为切点,杭州数智医掘金新蓝海

瞄准数亿过敏人群,以过敏数字疗法为切点,杭州数智医掘金新蓝海

武汉大学疑似出现霍乱病例

武汉大学疑似出现霍乱病例

期货不严格止损是超短线交易失败的根源

期货不严格止损是超短线交易失败的根源

,精细赛道也能走到上市!

,精细赛道也能走到上市!

预制菜,会有“刺客”吗

预制菜,会有“刺客”吗

推荐资讯

让区块链变成人人可用的工具,上海原创Web3.0操作系统是如何诞生的

让区块链变成人人可用的工具,上海原创Web3.0操作系统是如何诞生的

隐私之变|自我主张时代变革,从构建WEB3.0的ID体系开始

隐私之变|自我主张时代变革,从构建WEB3.0的ID体系开始

被投资圈盯上,风头超过元宇宙,Web3.0到底是啥?

被投资圈盯上,风头超过元宇宙,Web3.0到底是啥?

Web3.0,勾勒下一代互联网模样

Web3.0,勾勒下一代互联网模样

为什么说中国汽车产业已经真正“支棱”起来了

为什么说中国汽车产业已经真正“支棱”起来了

我在新能源汽车行业打工10年:从月薪2千涨至年薪40万,终于熬出头

我在新能源汽车行业打工10年:从月薪2千涨至年薪40万,终于熬出头

对话梅宏院士:数字化转型不是想不想,而是必须转

对话梅宏院士:数字化转型不是想不想,而是必须转

王兴继续“电商零售梦”:告别社区团购 美团优选变身明日达超市

王兴继续“电商零售梦”:告别社区团购 美团优选变身明日达超市

800字+两小时,掌握nlp自监督学习!文末福利!

不要错过文末福利❤

(有不少同学还答不上来自监督和无监督真正的区别 ,我不是针对谁 。)

无监督学习: 无监督学习不依赖任何标签值,通过对数据内在特征的挖掘,找到样本间的关系,比如聚类相关的任务。

自监督学习: 和无监督学习不同,自监督学习主要是利用辅助任务 (pretext)从大规模的无监督数据中挖掘自身的监督信息,通过这种构造的监督信息对网络进行训练,从而可以学习到对下游任务有价值的表征。

总结:: 自监督学习的监督信息不是人工标注的,而是是通过辅助任务 (pretext) 在大规模无监督数据中自动构造监督信息,通过得到的标签,就可以类似有监督学习一样进行训练。

自监督学习cv方向的视频,医学图像,自动驾驶等领域发展态势十分良好 ,比如基于对比学习的自监督学习方法《moco》的提出就对cv领域的相关研究产生了深远的影响。

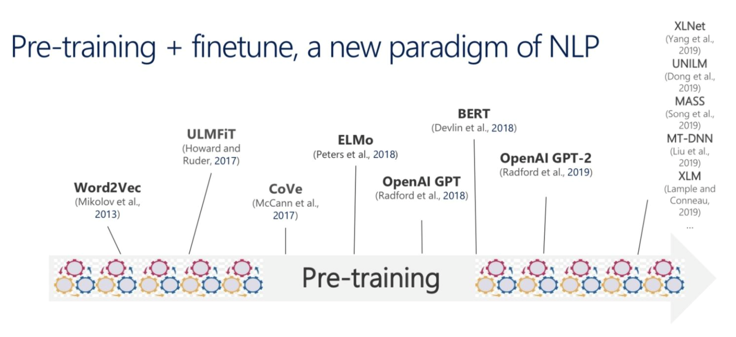

同理, 自监督学习在推动自然语言处理(NLP)领域取得了巨大成功 ,包括Collobert-Weston 2008 model, Word2Vec, GloVE, fastText等。系统以这种方式进行预训练产生的性能要比仅以监督方式进行训练时高得多。

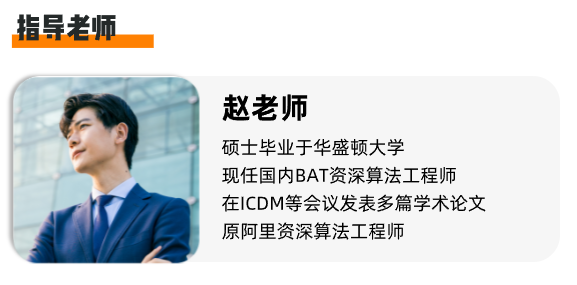

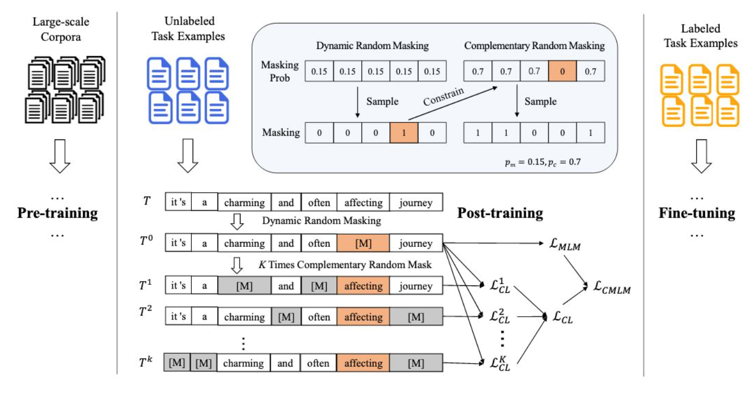

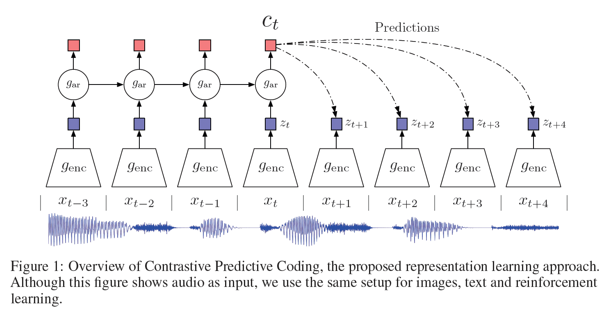

掌握自监督无监督学习在nlp领域的技术演化,就是在打地基! 16号晚深度之眼邀请到5年深度学习和机器学习经验,在ICDM等会议发表多篇学术论文的赵老师 来为大家讲解自监督无监督在nlp领域的技术发展要点,以及对比学习的重点。 从经典论文cpc (《Representation Learning with Contrastive Predictive Coding》)入手带你吃透nlp自监督学习。 最后还有nlp自监督学习学习路径推荐! 内容丰富,超值干货,不容错过。

扫描下方 二维码

0.1 元购课

购课后添加小享

以免错过 直播通知

并领取福利(文末)

详解 利用无监督文本,通过预训练任务学习更好的 单词表征 , 应用到下游任务 。预训练:word2evc -> ELMo -> GPT -> BERT -> GPT-2 -> XLNet -> RoBERTa

一个词在不同语境中的不同含义(context-aware)

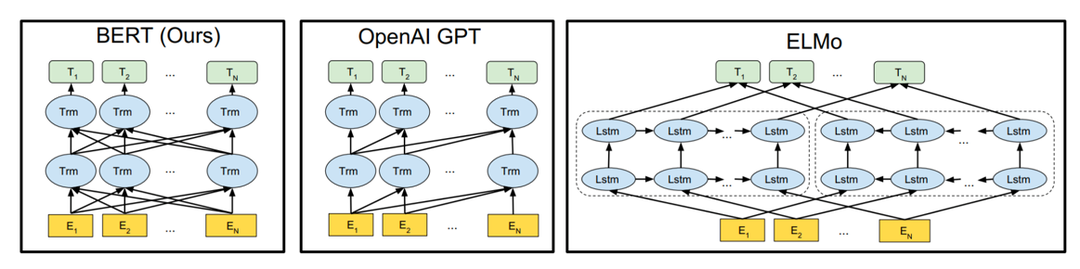

自回归语言模型和自编码语言模型区别

结合以上两方面技术难点串讲 ELMo , GPT , BERT , 双向Transformer ;两种新的预训练任务 MLM 和 NSP , RoBERTa ,XLNet,ALBERT,ELECTRA…等经典算法原理。

完全可以利用对比学习,学习到更好的 word/sentence 表示。

经典 CPC算法的特点:普适性算法可应用于CV、NLP、Speech、强化学习 通用的对比学习任务。

算法难点讲解及学习路径分享 在16号当晚直播课看哦!

扫描下方 二维码

0.1 元购课

购课后添加小享

以免错过 直播通知

并领取福利(文末)

价值198元的 AI环境配置教程 ,

购买自监督课程后 添 加小享免费 领取!

扫描下方 二维码

0.1 元购 自监督 课

购课后添加小享

领取AI环境搭建学习视频

本文部分内容来源于网络侵删

更多相关内容

-

【390】乐妈学习分享:2年时间我和乐乐共同学习了16期各种类型的软实力课程,飞速成长~

刻意练习 终身成长 第390篇 约2171字 草稿累积约619782字 往期文章请点击如下链接:

-

辛苦打工10年,只换来一身病痛:原来我竟是个铁憨憨!

01 来访者吴芳(化名)前来咨询时是一家公司的财务人员,她做了10多年的财务工作,但不知为何,总是...

-

CloudX云智能学院丨人工智能技术图谱,AI高阶——顶会论文

由阿里云天池倾力打造的AI技术学习图谱,配套有免费算力、珍稀数据集,钉钉群答疑等资源和服务,助力学...

-

中国PaaS市场群雄逐鹿,究竟谁能笑傲江湖

一家云服务商需要具备怎样的能力,才能在群雄逐鹿的中国PaaS市场笑傲江湖?群雄逐鹿的中国PaaS市场众所...

-

这届年轻人是真的很喜欢看直播学习!

哈喽,大家好,我是小谷~ 前有网友看 刘畊宏来锻炼身体,现有大家看 董宇辉(新东方直播老师)学英...

-

抖音评论引流有用吗

现在是秋天,早上和晚上全身都很冷!感觉就像风一样!但从另一个角度来看,秋天是丰硕的!这是一个收获...

-

深度学习论文精读[GAN]:利用深度生成先验进行多用途图像修复与处理

笔者最近在集中时间学习 对抗生成网络(GAN) ,特别是深度生成先验进行多用途图像修复与处理,...

-

还有这好事

点击?蓝字关注学姐,文末留言送80cm鼠标垫 作者:学姐 当你打算打比赛

-

26.1万栋经营性自建房存在安全隐患!检测鉴定人才缺口大,学习1个月,做懂鉴定的结构人!

7月8日,全国自建房安全专项整治工作推进现场会在浙江省杭州市召开。会议指出,各地区、各部门高度重视...

-

自主学习更智能

人工智能时代,身为公司的领导者,你认为公司发展过程中重点应该注意什么方面?首先,规范化管理对企业...

推荐阅读